Lernziele

- Du kannst Beispielsysteme und Einsatzzwecke der Generativen KI aufzählen:

- GAN (Einsatz eher für Bild, Ton, Video)

- Transformer, LLM (Einsatz für Texte)

- Du kannst die Funktionsweise eines GANs in deinen Worten und mit einem Schema erklären.

- Du kennst das prinzipielle Zusammenspiel von Transformer und LLM

Voraussetzungen

- Du verstehst, wie ein künstliches neuronales Netz (KNN) aufgebaut ist und wie das Lernen in einem KNN funktioniert.

- Du kennst folgende Begriffe:

- Neuron, Gewichte, Bias, input-, hidden-, outputlayer, Aktivierungsfunktion

- Backpropagation, Gradientenabstieg, Lernrate, Kostenfunktion («loss-function»)

- supervised-, unsupervised- und reinforced-learning

Generative KI

(Hauptquelle: https://www.computerweekly.com/de/definition/Generative-KI)

Vor dem Aufkommen der generativen KI waren Systeme mit künstlichen neuronalen Netzen (KNNs) vor allem für verschiedene Arten von Mustererkennung gedacht, ein typisches Beispiel dafür ist die medizinische Bildanalyse von Röntgenbildern auf Krebsverdacht.

Generative KI-Modelle gehen einen Schritt weiter und produzieren auf der Grundlage ihrer Trainingsdaten als Reaktion auf Benutzeranfragen neue Inhalte wie Texte, Videos, Programmcode und Bilder.

Aufgabe

Überlege dir zwei weitere Anwendungen von KNNs.

Lösung

z.B. Gesichtserkennung, Empfehlungssysteme, Betrugserkennung im Finanzwesen

«Geburtsstunde»

Generative KI wurde bereits in den 1960er Jahren in Chatbots eingeführt (noch ohne künstliche neuronale Netze).

Aber erst 2014, mit der Einführung von GANs («Generative Adversarial Networks» = «generative gegensätzliche Netzwerke», Erklärung folgt) konnte generative KI überzeugend authentische Bilder, Videos und Audiodateien von echten Menschen erstellen.

Aufgabe

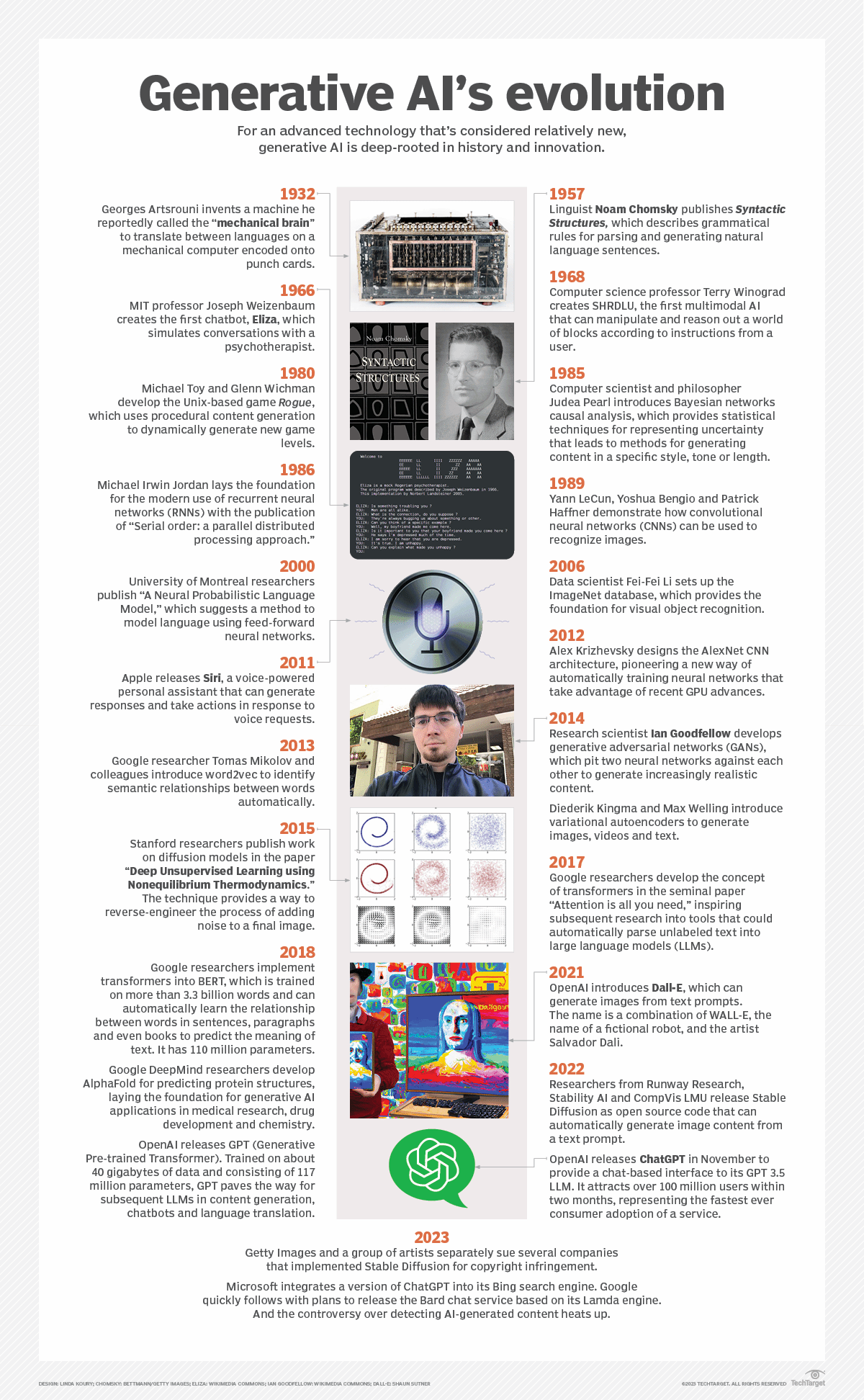

Lies aus der folgenden Abbildung heraus:

- Wann wurde ELIZA geschaffen?

- Wann wurde Siri veröffentlicht?

- Wie heisst der Wissenschaftler, dem die Erfindung der GANs zugesprochen wird?

- Wann wurde GPT entwickelt?

- Wann wurde ChatGPT veröffentlicht?

Lösung

- 1966

- 2011

- Ian Goodfellow

- 2018

- November 2022

weitere Fortschritte

Zwei weitere Fortschritte haben entscheidend dazu beigetragen, dass sich generative KI durchgesetzt hat: Transformers und die «grossen Sprachmodelle» («Large Language Models», LLMs). 2017 entwickelte Google das Konzept der Transformers, um Text in Large Language Models einzubringen.

Ein Problem ist, dass diese Techniken auch die in den Trainingsdaten enthaltenen Vorurteile, Rassismus, Täuschungen und Prahlerei (Übertreibungen) übernehmen können.

weitere Entwicklungen

Die geschilderten Technologien sind heute in vielen Anwendungen implementiert, sie werden aber bereits durch weitere Ansätze verbessert oder gar überholt.

Hier ein paar dieser Ansätze (ohne weiter darauf einzugehen):

- diffusion models (stable diffusion)

- variational autoencoders (VAE)

- Bidirectional Encoder Representations from Transformers (BERT, «das GPT von Google»)

GANs

Aufgabe

Lies zuerst die ganze Aufgabe!

- Lies die Einführung und den Abschnitt «Was ist ein Generatives Netzwerk?» der folgenden Seite:

https://www.codecentric.de/wissens-hub/blog/eine-kurze-einfuehrung-in-generative-adversarial-networks - Erstelle ein Schema des Lernzyklus. Dabei sollten mindestens vorkommen:

- Gabi (als Generator)

- Diana (als Diskriminator)

- Fälschungen

- echte Bilder

- Olivia (als Supervisor)

- Schaue dir das folgende Video ab der Stelle 03:13 bis 06:08 an:

- Erkläre in deinen Worten: weshalb darf der Discriminator am Anfang nicht zu gut sein?

Lösung

Was sind mögliche Anwendungen von GANs?

Aufgabe

Lies zuerst die ganze Aufgabe!

- Lies den Abschnitt «Was sind mögliche Anwendungen von GANs?» der folgenden Seite:

https://www.codecentric.de/wissens-hub/blog/eine-kurze-einfuehrung-in-generative-adversarial-networks - Recherchiere mindestens zwei weitere Anwendungen von GANs und fasse sie schriftlich in maximal drei Sätzen zusammen.

Anwendungen zur Bilderzeugung

- Dall-E: https://openai.com/dall-e-2 und https://openai.com/dall-e-3

- Midjourney: https://www.midjourney.com/

- Stable diffusion: https://stablediffusionweb.com/

Transformers

Transformer sind eine Art von KNNs für Texte, die es den Forschern erlaubt, immer grössere Modelle zu trainieren, ohne alle Texte im Voraus kennzeichnen zu müssen. Das geschieht dadurch, dass der Transformer versucht, die wichtigen Textstellen zu identifizieren – dieser Vorgang wird attention (Aufmerksamkeit) genannt. So wird es den Modellen ermöglicht, die Verbindungen zwischen Wörtern über sehr viele Seiten, Kapitel und Bücher hinweg zu verfolgen und nicht nur in einzelnen Sätzen. Neue Modelle konnten so mit Milliarden von Textseiten trainiert werden, was zu Antworten mit grösserer Tiefe führte. Transformer basieren auf LLMs.

LLM

Die menschliche Sprache ist nicht immer präzise. Sie ist häufig mehrdeutig und die linguistische Struktur kann von vielen komplexen Variablen abhängen, einschliesslich Slang, regionalen Dialekten und sozialem Kontext.

Die Technik des Natural Language Processing (NLP) kann verwendet werden, um freien Text zu interpretieren und ihn analysierbar zu machen. Es gibt eine enorme Menge an Informationen, die in Freitext-Dateien gespeichert sind. Bevor es moderne, auf Deep Learning basierende NLP-Modelle gab, waren diese Informationen für eine computergestützte Analyse nicht zugänglich und konnten nicht systematisch ausgewertet werden.

Im folgenden Video wird erklärt, wie NLP-Modelle mit Hilfe von Deep Learning erstellt werden:

https://www.youtube.com/watch?v=Io0VfObzntA (Dauer: 06:47)

Die Textgenerierung passiert nun in 6 Schritten:

- Die Daten werden gefiltert, um zu bestimmen, was in den am Ende des Prozesses erstellten Inhalt aufgenommen werden soll. In dieser Phase werden die Hauptthemen des Quelldokuments und die Beziehungen zwischen ihnen identifiziert.

- Verstehen der Daten. Die Daten werden interpretiert, Muster werden identifiziert und sie werden in einen Kontext gestellt. In dieser Phase wird häufig maschinelles Lernen (ML) eingesetzt.

- Strukturierung des Dokuments. Es wird ein Dokumentplan erstellt und eine Erzählstruktur gewählt, die auf der Art der zu interpretierenden Daten basiert.

- Aggregation von Sätzen. Relevante Sätze oder Teile von Sätzen werden so kombiniert, dass sie das Thema genau zusammenfassen.

- Grammatikalische Strukturierung. Grammatikalische Regeln werden angewandt, um einen natürlich klingenden Text zu erzeugen. Das Programm leitet die syntaktische Struktur des Satzes ab. Es nutzt diese Informationen, um den Satz grammatikalisch korrekt umzuschreiben.

- Darstellung der Sprache. Die endgültige Ausgabe wird auf der Grundlage einer Vorlage oder eines Formats erzeugt, das der Benutzer oder Programmierer ausgewählt hat.

Demonstrationsbeispiel eines vereinfachten Textgenerators

Aufgabe

- Schau dir folgendes Erklärvideo zur Bedienung des Beispiel-Textgenerators «SoekiaGPT» an.

https://www.soekia.ch/GPT/SoekiaGPT-Video.mp4 - Starte SoekiaGPT und erkunde das System mit verschiedenen Dokumentenkollektionen.

https://www.soekia.ch/GPT/ - SoekiaGPT hat gewisse Übereinstimmungen, aber auch gewichtige Unterschiede zu einem System wie z.B. ChatGPT. Erstelle eine Liste mit Gemeinsamkeiten und Unterschieden von SoekiaGPT und ChatGPT!

Anwendungen zur Textzeugung

- https://chat.openai.com/

- 12 ChatGPT-Alternativen, mit Beschreibung: https://elevatex.de/de/blog/it/chatgpt-alternative-die-12-besten-kis-2023/